(※シリーズ「AI入門」は、筆者が、2023年・2024年に愛知県中小企業診断協会の理論政策更新研修での登壇内容「AIを活用した中小企業診断」の補足資料として、本サイトに掲載しています)

みなさんこんにちは、デジタルボーイです。

本シリーズ「AI入門」の第2回となる記事となります。今回はAIの歴史についてざっくりとご紹介したいと思います。

デジタルボーイです。

データサイエンス歴20年以上のおっさんです。中小企業診断士として、データサイエンス、WEBマーケティング、SEOに関するデータ分析、コンサルティングの仕事をしています。自己紹介の詳細はコチラ

AIは意外と古くからある?

AIって、ここ最近になって爆発的に普及しましたね。なので、ここ最近で作られた理論体系なのかと思うかもしれません。でも、実は、結構前から研究されていた分野だったりします。

例えば、僕も大学院時代(20年以上前です)は機械学習という手法を使ったデータ分析について、研究していました。この機械学習という手法は、現在、AIによるデータ分析の主要な技術的方法となっています。ただし、僕が研究していたころは、「人工知能の研究をしていた」とは僕自身も全く思っていなくて、所属していた研究室も人工知能の研究室ではなくて、データ解析や心理学における統計学を研究する研究室でした。

何が言いたいのかというと、昔から存在した技術ですが、それを最近になって「AI技術」とよばれるようになった技術って、結構あるということです。なので、いきなりAI技術がここ最近になって、まったくゼロから生まれというものでもないんですね。

では、AIの歴史(研究史)について、見ていきましょう。

年譜からみる、AIブームの浮き沈みと歴史

AIの誕生と第1次AIブーム:1950年〜1960年

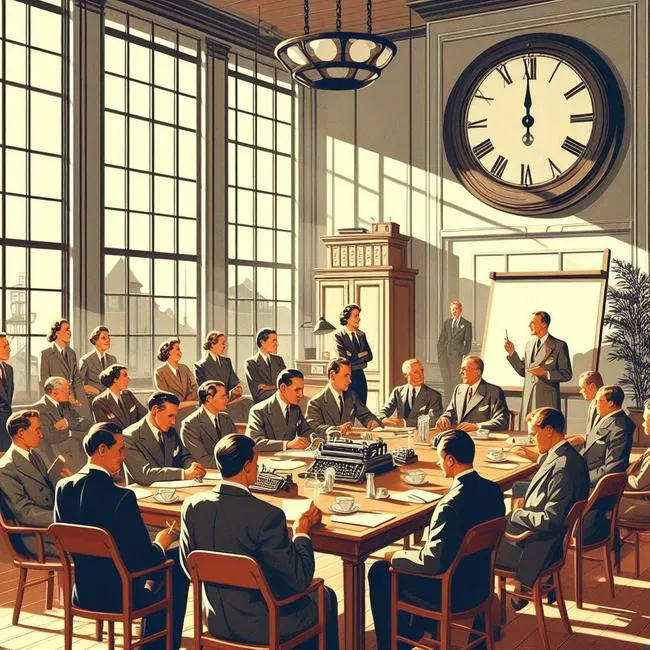

「人工知能」(Artificial Intelligence)という概念は1956年のアメリカで開催されたダートマス会議で初めて、公式に提唱されたと言われています。

この会議では次のような研究者が、参加し、人工知能について、議論したと言われています。

- ジョン・マッカーシー(John McCarthy)

「人工知能」という用語を初めて提唱した人物。AI研究の草分け的存在。 - マーヴィン・ミンスキー(Marvin Minsky)

AI分野の第一人者の1人。認知科学や神経科学の研究を通してAI理論を発展させた。 - クロード・シャノン(Claude Shannon)

情報理論の創始者。コンピュータと論理的な情報処理の関係性を明らかにした。 - ハーバート・サイモン(Herbert Simon)

意思決定理論の先駆者。AI研究を通じて人間の意思決定プロセスの解明を目指した。 - アラン・ニューウェル(Allen Newell)

シンボル処理アプローチによるAIシステムの開発に尽力した研究者の1人。

ダートマス会議の後、研究者による人工知能の研究が進みます。この結果、コンピューターによって、特定の問題(迷路や数学の定理やゲーム)に対して、一定の解を求めることができました。このようなことから、「人工知能とかいう、ものすごい技術があるんやな!」といった感じで、界隈では、AIに対して、大きな期待を寄せました。

このようなことから、「AIすげ〜!!」という感じでものすごい期待からブームがきました。このころを第1次AIブームと呼ばれています。

冬の時代:1970年代ごろ

しかし、実際には、その期待は過剰なものだったです。というのも、AIを使った問題解決は、ある程度決まりきった特定の問題(迷路や数学の定理やゲームなど)であって、人間が生活する上で直面する複雑な問題については、まったく処理できないものだったんですね。

AIに対する世間の期待が過剰だったこともあり、実際のAIでできることがだんだんわかってくるにつれ、「なんや、こんなことワシにもできるわ!」といった感じで、「実はAI大したことない説」が広まります。これにより、AIブームは急速に冷め、冬の時代が到来しました。

第2次AIブーム:1980年代ごろ

そして、1980年代は、AIの第2次ブームが起こります。特に、エキスパートシステムという人の持つ知識をデータベース化し、瞬時に回答をする仕組みが作られ、注目されました。

このエキスパートシステムというのは、ある特定の専門分野の専門家がもっているその人の知識を一旦データベース化し、それを効率よく検索させるようにプログラム化したものです。ここら辺は、今のAIともかなり近い仕組みですね!

このデータベース化した知識と検索機能により、専門家でなくとも、AIが専門家を模倣して、質問に対して回答するというような、対話型のシステムを構築しました。今でいう、AIチャットボットの原型のようなものですね。

これにより、またもや「AIすげ〜!」となり、AIブームがやってきました。

冬の時代:1980年代ごろ

エキスパートシステムの台頭による第2次AIブームはすぐに廃れてしまいます。AIブームが廃れた、大きな理由の一つは、AIに食わせる知識をデータベースするするのがめんどくさいという点でした。例えば、医療用のAIを作るにあたて、このような症状だったらこれ、このような症状だったらこれ、というようなパターンをコンピューターに管理しないといけません。でも、このころのコンピューターは今ほど使いやすいものでもないですし、膨大な知識をデータ化することが、とてもめんどくさかったようです。

「人間がやれば一瞬なのに、それをわざわざデータベース化する意味あるんか?」という感じで、知識のデータベース化の難しさから、このエキスパートシステムは多くの分野で広まることなく、ブームが冷めていきました。

第3次AIブーム:2010年〜(→NEW!)

AIに食わせるデータベース化の難しさからAIは冬の時代に突入しました。しかし、2000年ごろからビッグデータと言われる、大規模データが急速に広まります。インターネット技術によって大規模データのやり取りが簡単になったり、ハードウェア技術の進歩によって、大規模データを安価に保管したり、大規模データをスピーディーに操作することもブームの手助けになりました。

第2次AIブームの弱点だった知識のデータベース化は、ビッグデータの活用により多くが解決できたんですね!

また、最近の生成AIなんかでも活躍しているディープラーニングという技術ですが、この技術の核となる理論(誤差伝播学習理論)は、実は1970年代には確立されていました。しかし、その頃のコンピューターの処理能力が貧弱だったので、この理論を実装させることができなかったんですね。それが、今のコンピューターやインターネットなどの発展によって実装できるようになり、現在の生成AIブームに繋がっています。

このようにAIというのは、理論・データ・コンピューターの処理能力、の3つが高度に重なることで実現できているんですね!

AIの今後の展望

ここからは、僕の個人的な想像になります。ChatGPTなんかを使って思うんですが、文字で質問を入力するのって、結構手間なんですよね。とは言え、音声でChatGPTに質問するインターフェースも、今のところそんなに便利ではありません。

今後は、テキストで質問するんではなく、会話するような感じで生成AIとやり取りできるように進歩するんだと思います。

そして、さらにそれが進むと、会話すらめんどくさくなる、ということもあると思います。そうすると、口にしなくとも、考えただけで、その考えがAIに伝わるといいですよね。攻殻機動隊の世界のように、脳が直接コンピューターと繋がる時代もそんなに遠くないと思います。

次のコラム

前回のコラム