みなさん、こんにちは。デジタルボーイです。ここでは、データ分析の初心者に向け、これまでの仕事や勉強での経験からデータ分析のデータ分析の全体像について、解説したいと思います。

また、個別のテーマに関する記事は以下にありますので、よかったらみてください!

デジタルボーイです。

データサイエンス歴20年以上のおっさんです。中小企業診断士として、データサイエンス、WEBマーケティング、SEOに関するデータ分析、コンサルティングの仕事をしています。自己紹介の詳細はコチラ

そもそもデータ分析とは何か?

データ分析は、英語で言うと「data analysis」と言います。

data・・・情報や情報の塊を意味する。

anlysis・・・複雑な現象や情報を理解しやすいように分解し解明すること

ここから、データ分析は、「複雑な情報の塊を、わかりやすいように解明する行為」と考えることができます。

例えば、スーパーの店長にとって、全てのお客さんの行動を、頭の中だけで把握するには、現実は複雑すぎますね。

こんな場合、データ分析とは、次のような行為と考えることができますね。

複雑な情報の塊・・・お客さん全員の購買行動

わかりやすいように解明する行為・・・購買行動をデータ化し、わかりやすいように解明し、店舗運営に役立てる行為

僕もデータ分析を商売にしていますが、詰まるところ、頭の中だけで物事を把握できないから、データ分析をやっているんだと思います。

また、データ分析のツールについては、ExcelやAccessなどの汎用ツールを使う場合やPythonやRといったプログラミング言語を使う場合や、SASやSPSSといった市販のツールを使う場合もあります。ここら辺は、データ分析をすすめる環境や状況に合わせて適切なツールを選ぶ必要があります。

ここら辺のデータ分析の初歩については以下にもまとめてありますので、よかったら見てみてください!

データ分析はどこから始める?分析の方針決め

データ分析の初心者の方が、「これからデータ分析をしよう!」と思った時、まずはじめにつまずきやすいところは、「何から分析すればいいのか分からない」という点じゃないでしょうか?データ分析の視点を挙げ出すと無数にあるため、何から手をつけていいか分からないということは、よくあると思います。

そんな時に重要になる、分析の「視点」について、今回は大きく2つ「探索的分析」と「仮説検証分析」について解説したいと思います。この視点を身につけておくと、データ分析をはじめるにあたっての、何から手をつければいいのか?の有効な指針になるはずです!

探索的分析とは?

例えば、僕のようなデータ分析コンサルタントは、特に事前知識などもなく、建設業だったり、人材派遣業など、全く知らない業界から依頼を受けてデータ分析をすることになったりします。このような場合はその分野の分析を始めて行うため、ざっくりとデータの概要を調査して、データからその会社の状況や業界の状況を眺めることがあります。

こんな感じの、特に事前知識がない状態でデータから色々、確認しながら進めていく分析プロセスを探索的分析と言います。このように探索的分析では、分析時点で分析の方向性や仮説を定めなくても分析プロセスを進めることができる反面、分析を始めた段階で確固たる分析の方向が定まっていないため、分析のゴールも定まっておらず、どこまでやったら分析が終わりかということが分かりづらい点もあり、あまり、初心者にはお勧めしません。

仮説検証分析とは?

仮説検証分析の分析プロセスでは、その業界に精通している人だったり、何かしらの知見がある場合に、ある仮説を立てその仮説が正しいのかどうかを検証するプロセスで実施する分析となります。多くの場合、データ分析を行おうと考えている人は、何かしらのその分野での知見がある場合が多いと思うので、この仮説検証分析のプロセスを実施することが多いでしょう。

僕のような分析コンサルタントの場合は、例えばクラアイアント企業の経営改善させるための対策(仮説)を立て、その仮説が正しいのかどうかを検証するための分析プロセスとしても、実施します。

先ほども探索的分析でも解説した通り、基本的にはデータ分析初心者は、この仮説検証分析のプロセスで分析を始めることをお勧めします。

ということで、以降では仮説検証分析の進め方について解説しますね。

この仮説検証分析については以下に詳しくまとめてあるので、よかったら見てみてください!!

データ分析は何が面白い?

僕自身は大学2年からデータ分析にハマってしまい、年齢40を過ぎた今でもデータ分析を仕事としています。なんで、こんなに長くデータ分析に携わってこれたかと言うと、やっぱりデータ分析が面白い!ということに尽きると思います。個人的にデータ分析を面白く感じるところは、だいたい次の4つになります。

データ分析の面白さ1:素人が、未知の領域で力を発揮できる!

まず第一に挙げる、データ分析の面白さとしては、ほとんど詳しいことは知らない未知の分野や領域でも、データを分析することで、その道のプロでもわからないことを解明できる、という点です。

データ分析の面白さ2:勉強した分だけ、技術が身に付く!

例えば、経済学の勉強を毎日少しずつ地道にしたとしましょう。その勉強を1年間続けたとしても、勉強の結果、実際に経済を動かせるかというと、そんなことは普通はありえないと思います。また1年勉強したところで、実際の仕事に役立てれるかというと、そうでもないと思います。

でも、データ分析の勉強を毎日少しずつでも地道に勉強したとしたら、その人は、1年前の自分に比べて、格段にデータ分析の実力は付いているでしょうし、実際にデータ分析ができるだけの技術を習得することも十分可能です。

このように、データ分析を面白いと感じる理由の一つに、

「勉強すればしただけ、データ分析の技術が身に付く」ということが挙げられると思います。

データ分析の面白さ3:今日勉強したことが、明日仕事で使える!

データ分析の面白さ2の「勉強した分だけ、技術が身に付く!」につながることですが、データ分析の技術ははそのままビジネス場面で利用できるため、仕事でのスキルアップの方法としてもとても魅力的です。

例えば、仕事で英語が必要だったとしても、前日英語の勉強をして、翌日仕事で使えるかというと、普通は、そんんなことはありえないでしょう。

このように、データ分析を勉強すれば、勉強しただけのリターンがすぐ得られるというのは、とても魅力的な分野ですよね!

データ分析の面白さ4:プログラミング自体が面白い!

僕は普段、Pythonというプログラミング言語を使って分析をしています。で、プログラミングってやり出すと、めちゃくちゃ面白く、ハマります。ゲームをやっている感覚に近いですね。ゲームをやりながら仕事になるんだから、データサイエンティストは魅力的ですよね!

また、データ分析の面白さについては次のページにも詳しく書いてあるので、よかったら見てみてください!

データ分析にAIを活用するポイント

最近ChatGPTなど、AIがかなり話題になっていますが、データサイエンスの分野でもAIはかなり前から使われています。データサイエンスでAIを使うことで、作業はかなり効率化されます。AIができるデータ分析についてはざっと次のようなことが挙げられます。

未来を予測する

過去のデータから未来のデータを予測するために利用されます。

例・・・需要予測、株価の予測、不動産の価格予測、人口予測などです。

ちなみに、世間一般でAI予測について、少々誤解があるようなので、補足です。

グループ間の違いの特徴を割り出す

先ほどのスーパーの例で言えば、複数の店舗には好調な店舗と不調な店舗がありました。では、好調な店舗と不調な店舗では何が違うのでしょうか?

このような観点で、複数のグループで、特にその違いが鮮明に出ているような特徴を、例えば「不調な店舗グループは店頭プロモーションが月3回以下である」といったルールとして抽出することもAIは可能です。

複雑なデータを分類する

例えば、数百人分の社員名簿があったとします。名簿上で各社員を「社歴で別ける」とか、「年齢で別ける」とか、1つの切り口でデータを別ける作業を依頼された場合、そんなに苦労しませんよね。特にAIを使わなくても人間の力で可能です。

しかし、それが、年齢×社歴×出身地×・・・などというように、切り口が3つ、4つ、5つ、・・・と増えていくとどうでしょう?Excelで分けようとしても関数に「if(aaa, bbb, if(ccc, ddd, if(eee,ffff・・・」と、切り口の数だけ、if文を入れ子にした関数を作る必要もあり、非常に大変です。

しかも、その切り口が、元々決められたものならいいのですが、データの状況に合わせて、色々、試しながらデータを見る必要があるなどの場合、かなり煩雑な作業になります。

このような場面で、AIを使うことで複雑なデータから、規則性やルールを見つけ出しグルーピングが可能です。

例・・・スパムメールの分類、病気や疾患の分類、文字の分類、不良品の分類等です

おすすめ商品の抽出

あなたがショップの店員だったとして、その人の好みやこれまでの購買履歴から、おすすめ商品をご案内する場合、何人くらいのお客さんなら可能でしょうか?1人や2人なら、楽勝でしょう。これが、10人、20人になってくると、ちょっと怪しいですよね。100人、200人であれば、常人にはほぼ不可能でしょう。

このようなおすすめを何万人のお客さんにも正確に案内することがAIは可能です。

こんなイメージでこれまで人の手だとかなりの時間がかかっていた分析も、すんなりAIによってスムーズに実施することができるようになりました。

データ分析のAI活用については次にも詳しく書いてあるのでよかったら、見てみてください!

データ分析に使われる統計について

データ分析の手法の多くは統計分析の手法に基づいています。

さらに、データ分析の理論的な発展や理論的な正確性についても統計的な理論が基礎となっています。

そのため、データ分析を学術的に研究しようとした場合、統計学の研究は必要不可欠なのですが、では、現実場面では「統計学の知識がなければ、データ分析ができないか」というと、そういうわけでもありません。

例えば、自動車は、エンジンを動力源とした機構を持った4輪の乗り物ですが、自動車の動力機構を理解しなければ自動車の運転ができないかというと、そうでは無いですよね。もちろん、自動車の内部の構造や仕組みを理解していれば、自分で整備や修理も可能です。そのため、自動車の構造について詳しく理解しておくことが、自動車を保有する上で無駄になるというわけでもありません。自動車を運転するために、自動車の構造を理解することはアドバンテージになるが、かといって必ずしも必要というわけでもない、といったところでしょう。

このような関係が、データ分析と統計学の知識と言えるでしょう。

データ分析をする上で、統計学の知識がたくさんあった方が良いに越したことはありませんが、なくてもどうにかなるというのが実情では無いでしょうか。

最低限押さえておくべき統計としては、以下になります。

データの中心を要約するための統計量

平均値(Mean):皆さんご存知のいわゆる平均です。手元データの全ての値の平均です。

対象データの合計をデータ数で割ることで算出します。

$$ \bar{x} = \frac{1}{n} \sum_{i=1}^{n} x_i \ $$

中央値(Median): 手元データを半分に分けた時の値です。

最頻値(Mode): 手元データで最も件数の多い値です。

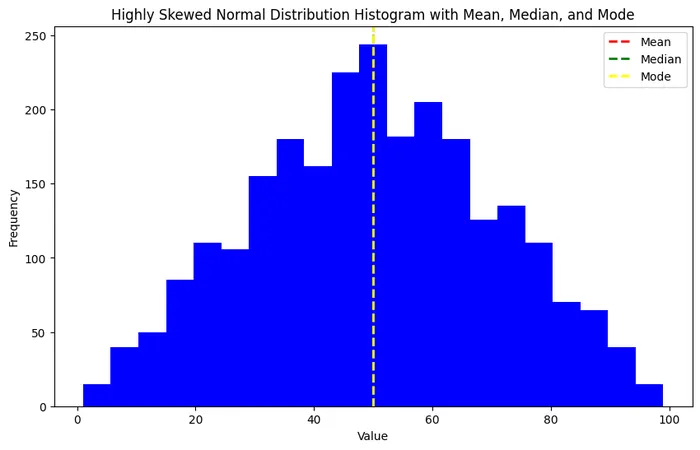

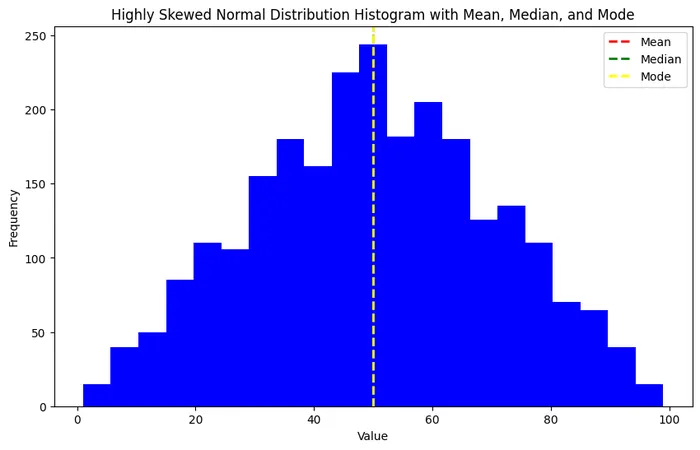

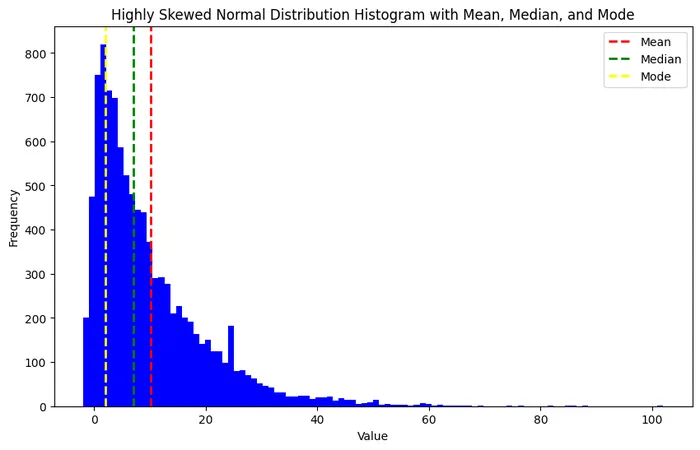

データが整数で、左右対称の分布の場合、概ね、平均値・中央値・最頻値は分布の真ん中で一致します(下図左参照)。

一方、歪んだ分布の場合、平均値・中央値・最頻値は一致しません(下図右参照)。

データのバラツキを要約するための統計量

分散(Variance): 手元データの分布が平均値からどれだけ散らばっているか

を示す指標です。

言葉で表すと「平均からの偏差の2乗の平均」

$$ \sigma^2 = \frac{1}{n} \sum_{i=1}^{n} (x_i – \bar{x})^2 $$

標準偏差(Standard Deviation): 分散の平方根で計算します。

$$ \sigma = \sqrt {\frac{1}{n} \sum (x_i – \bar{x})^2} $$

偏差値:標準偏差から計算する指標

$$ 偏差値 = 50 + 10 \times \frac{(得点 – 平均値)}{ 標準偏差 } $$

標準偏差も偏差値も分散から計算される統計量です。偏差値は受験生の中における自分の相対的な位置を知るための指標としてよく使われますね。

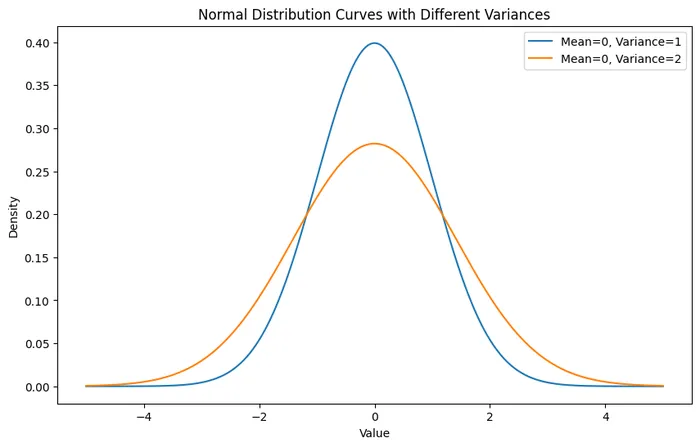

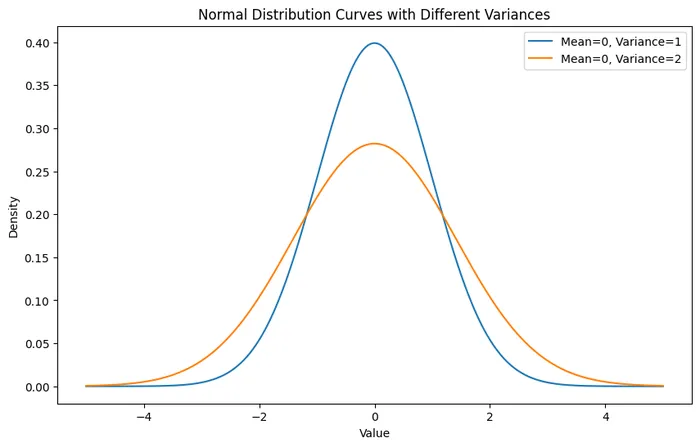

以下のグラフは分散が1の分布と2の分布(正規分布)を同時にプロットした図になります。

図:同じ平均で分散が異なる二つの分布の例

分散が大きい分布は、バラツキも大きく、横に広がった分布であることがわかると思います。

2つのデータ間の関係を表す統計量:相関係数

身長と体重や、国語の点数と英語の点数など、2つのデータ間の関係を表す指標に相関係数という統計量があります。

相関係数は次のような性質があります。

- 相関係数は-1から+1の間の値を取ります。

- 相関係数の符号(正または負)は、二つの変数間の関係の方向を示します。

相関係数の符合がプラスの場合、正の相関関係があると言います。

一方の変数が増加するともう一方も線形に増加します。

逆に相関係数の符合がマイナスの場合、負の相関関係があると言い、一方が増加するともう一方が線形に減少います。 - 相関係数の絶対値は、関係の強度を示します。絶対値が大きいほど、関係は強く、小さいほど弱くなります。

ちなみに、相関係数で測れる2つの変数間の関係は、正確には、2つの変数間の直線的な関係といいます。

例えば、2つの変数間に曲線的だけれども強い関係があった場合も、相関係数は曲線的な関係を図ることはできません。

ここら辺の統計については以下にまとめてあるので、よかったら見てみてください!

データの収集の方法

また、データ分析を進める上で、データの収集は必ず必要になります。例えば、次のような場合がありますね!

- 手元のデータの分析をする上で、さらに付加的な情報が欲しい場合

- 公開されているデータを分析し、勉強したいとき

- 世の中の流れなど、市場の調査が必要な場合

特に、必要なデータが社内など、身近な場所で収集できない場合は、インターネット上などにあるデータを収集する必要があります。

インターネット上では、ざっと次のようなデータが無料で公開されています。

無料で、ダウンロードが可能なデータ一覧

e-Stat

政府統計の総合窓口で、国勢調査、経済センサス、家計調査など、

非常に多岐にわたる国や自治体が行なっているデータが無料で公開されています。

日本で公開データの収集を行いたい場合、まずはここから始めてみると良いでしょう。

jSTAT MAP

上で紹介した、e-Statで公開されている国勢調査、経済センサスなどを

地図上で閲覧できるサイトです。

僕も昔、エリアマーケティングの分析エンジンを開発したことがあるのですが、

このようなGISツールを無料で利用できるのは非常に画期的だと思います!

エリアマーケティングに携わっている人などはぜひ、このサイトも利用してみると良いでしょう。

https://www.e-stat.go.jp/gis/gislp/

非常に多岐にわたる国や自治体が行なっているデータが無料で公開されています。

日本で公開データの収集を行いたい場合、まずはここから始めてみると良いでしょう。

気象データ

気象庁がエリア別に過去のデータを公開しています。

需要予測や来場者数予測などを行う場合に、気象データを利用したい場合など、

このデータを利用すると良いでしょう。

https://www.data.jma.go.jp/stats/etrn/index.php

土地総合情報システム

国土交通省が全国の不動産の取引価格情報や地価の情報を公開しています。

不動産関連のデータ分析をする際は、e-StatとjStat Mapに加えて、こちらのデータも

非常に有用です。

https://www.land.mlit.go.jp/webland/

JAXAデータ提供サービス

こちらでは、衛生データなどを無料で公開しています。

ハイテク機器など、衛生データを活用した開発を行う場合も多く、そのような場合に、こちらのデータは有用なのではないでしょうか

https://earth.jaxa.jp/ja/data/

これらは無料データで、簡単にダウンロードして使うこともできます。僕自身もデータ分析コンサル時に、付加的な情報が欲しい場合、これらのデータを分析データと連携し、プロジェクトを進めることはよくあります。

ここら辺のデータの収集については以下にも詳しく解説してあるので、よかったら見てみてください!

データの集計

多くの場合、データ分析というプロジェクトの中の一つの作業としてデータの集計があります。例えば、アンケートデータの分析プロジェクトを例にとって見ていきましょう。

- 企画

- 仮説立案

- アンケート項目の作成

- アンケートの実施

- データの集計

- データの分析

- 結論

概ね、このような作業の流れで進めると思います。

この内、狭義の集計作業は5の「データの集計」となります。

僕の感覚では、ここでのデータの集計作業は、アンケートデータの入力作業や件数の集計、性別・年齢・居住エリアなどのフェイス項目の集計、アンケート項目ごと平均の集計、自由記述のまとめ・・・などある程度、機械作業や単純作業で可能なデータの取りまとめ作業を指しますね。

また、データの集計方法は大きく以下に分けられます。

- 単純集計

- クロス集計

- グラフ化・ビジュアライズ

- 相関

単純集計

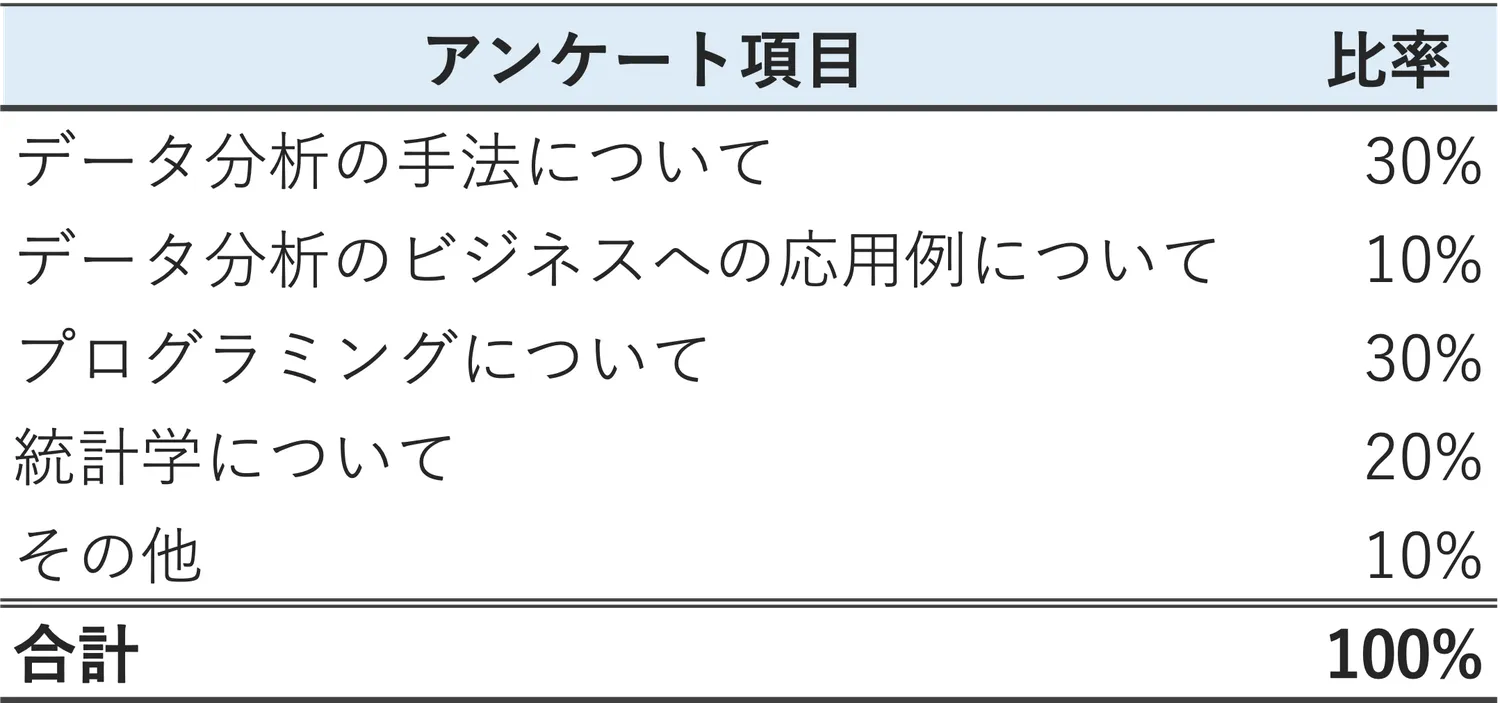

一つのデータに対して、集計を行うことを単純集計と言います。以下はアンケート結果と単純集計の例となります。

例:アンケート項目「データ分析に関して、これから最も勉強したい内容は次のうち1つ選んでください」

- データ分析の手法について

- データ分析のビジネスへの応用例について

- プログラミングについて

- 統計学について

- その他

単純集計結果は以下の通りです。

例:アンケート結果の単純集計の例

上記の例では複数選択が不可のため合計値は100%でしたが、もし、複数選択が可能なアンケートの場合の合計値は100%を超えます。

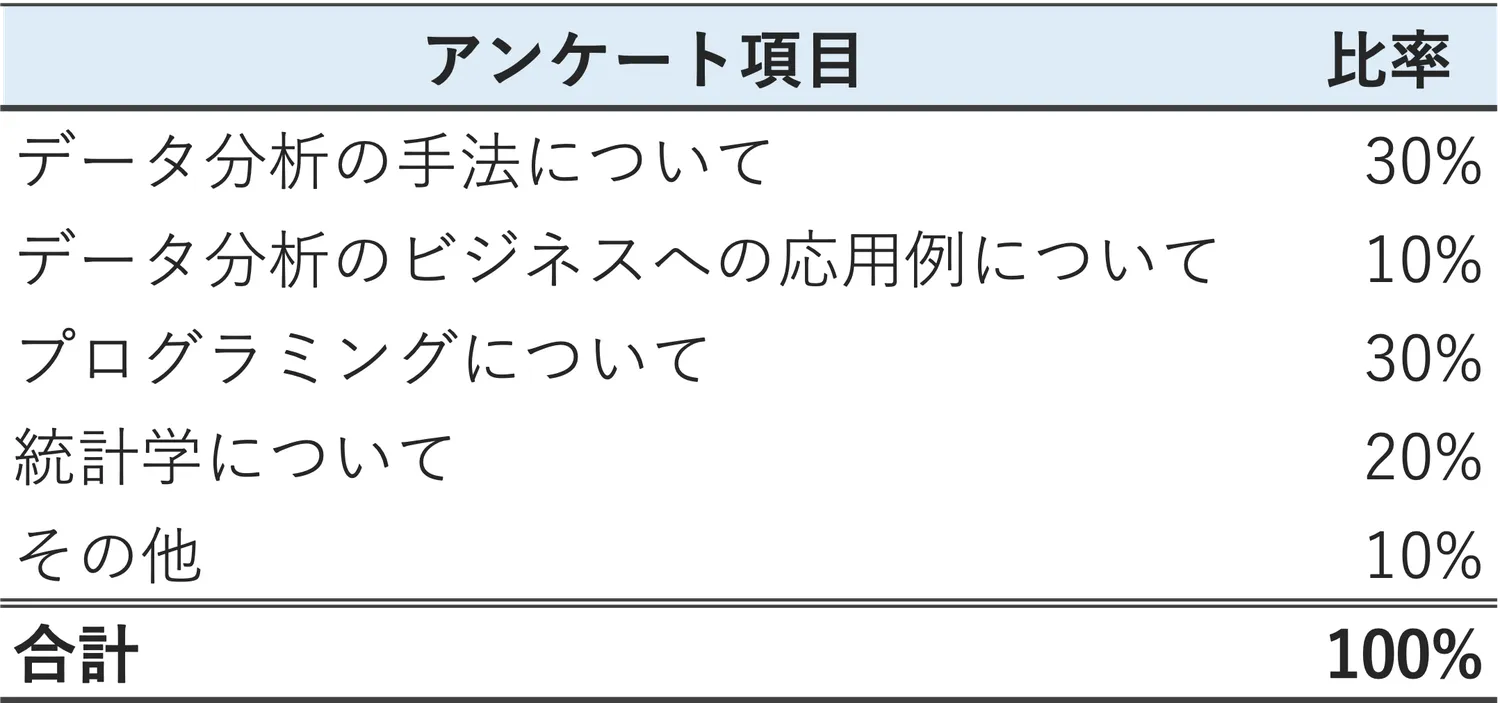

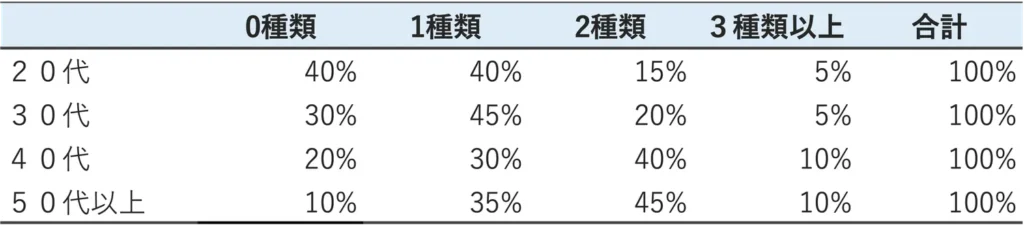

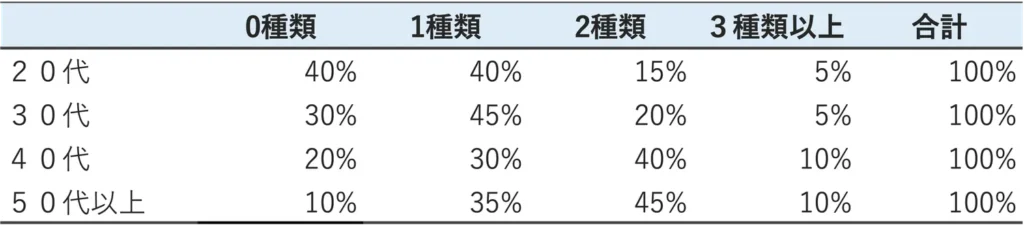

クロス集計

単純集計の後は、クロス集計についてです。

先ほどの単純集計は1つのデータに対して集計を行う手法でした。クロス集計は2つ(2つ以上)のデータに対して行う集計です。

例で見ていきましょう。

例:アンケート項目「あなたがデータ分析業務で使うプログラミング言語は何種類ありますか?」

について、年齢別のクロス集計結果は次の通りです。

このように、縦と横で2つのデータをクロス集計表で表します。

ちなみに、表中の、上側を表頭といい、左側を表側という場合もあります。

グラフ化・ビジュアライズ

続いて、グラフ化やビジュアライズについて見ていきましょう。数値をグラフにする理由はいくつかありますが、主に次の3つでしょう。

- プレゼンテーション等で数値をわかりやすく見せるため

- データに外れ値(極端に離れた一部の値)や異常値がないかを探るため

- データ全体の傾向を把握するため

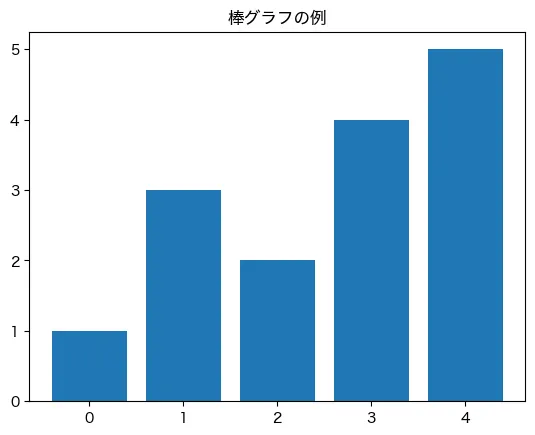

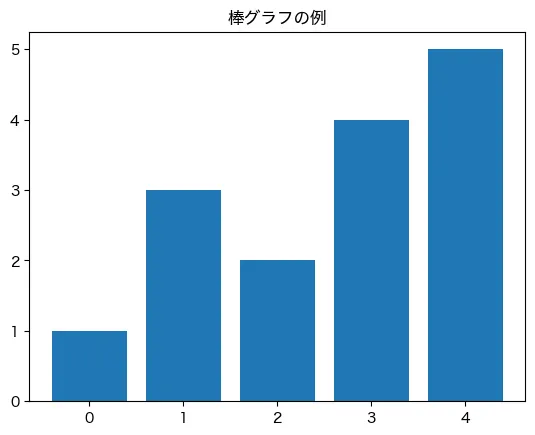

例えば、棒グラフは、グラフの中でも最もポピュラーなグラフですね!

棒グラフの例

まずは、棒グラフで集計できないか、を考えてみるといいでしょう。

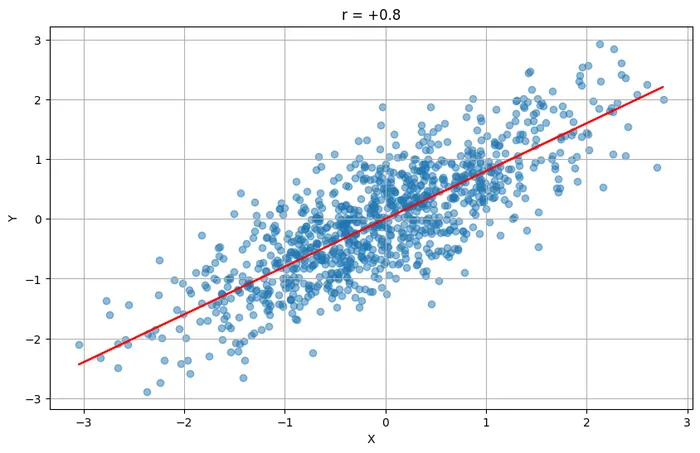

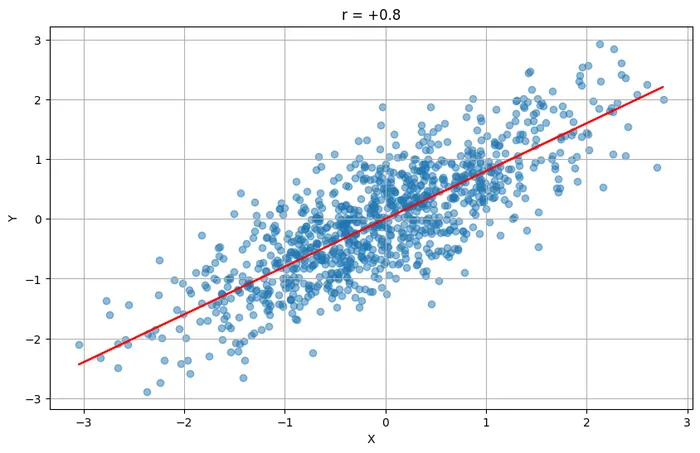

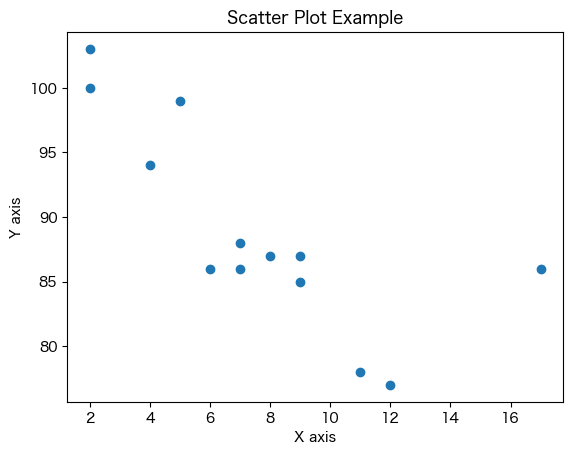

相関と散布図

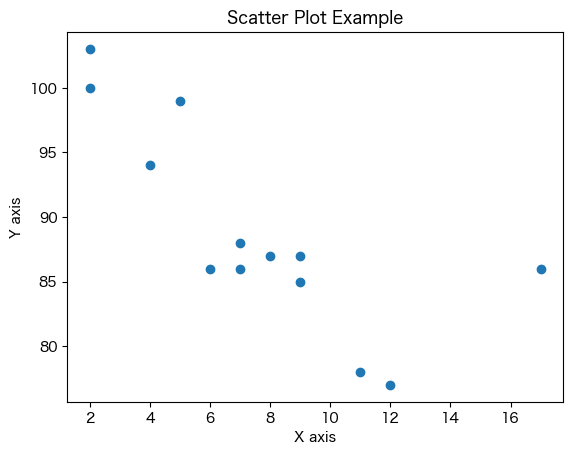

2つの変数の関係性を集計しグラフ化する際には、次の散布図が非常によく使われます。

散布図の例

例えば、国語の得点を横軸、と数学の得点を縦軸などでグラフ化します。

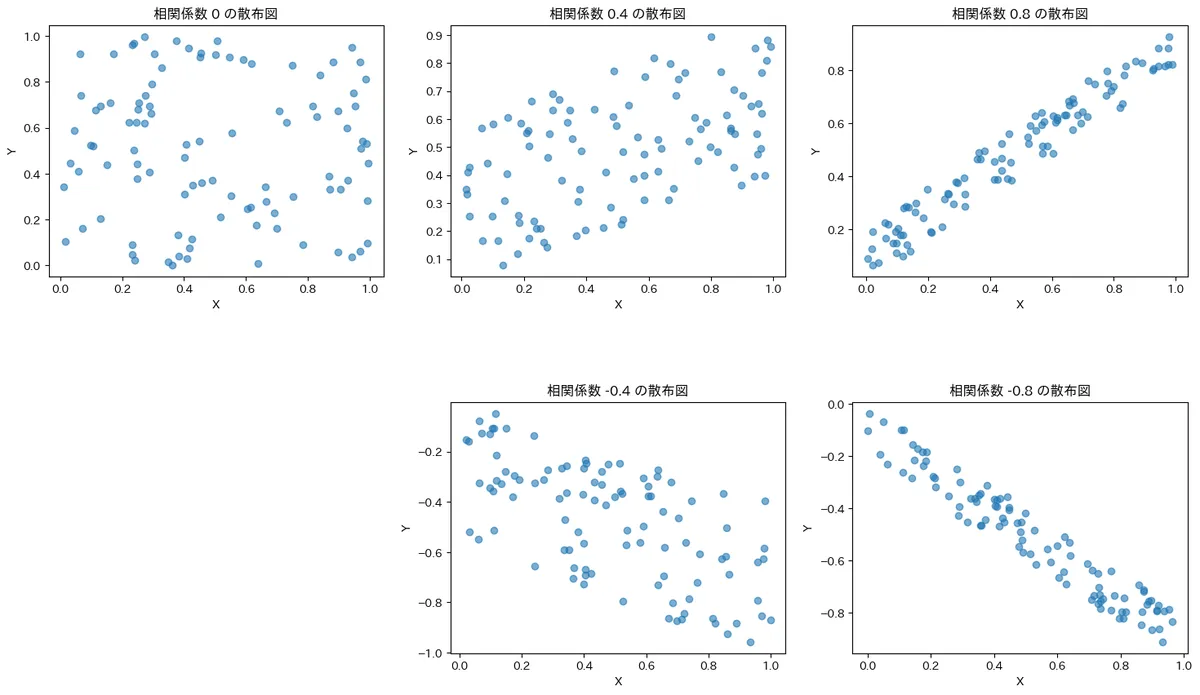

また、相関係数という統計量も散布図と一緒に使われる指標です(正確にはピアソンの相関係数)。この相関係数は−1から+1までの範囲をとります。

以下はそれぞれの相関係数が+0.8、+0.4、0、−0.4、−0.8の5つのパターンで作った散布図の例です。

様々なパターンの相関係数で作った散布図の例

相関係数はグラフを見るとわかるように、次のような性質が見られます。

- +の場合は比例関係、ーの場合は反比例の関係

- 数値(絶対値)が大きいほど直線的な関係が強い

- 数値(絶対値)が小さいほど直線的な関係が弱い

ここら辺のデータの集計については以下にも詳しくまとめてあるのでよかったら見てみてください!

データ分析のためのおすすめの無料ツール3選

これまでデータ分析の内容について解説しましたが、やっぱり、データ分析を進める上でツールは必要不可欠です。とはいえ、データ分析初心者にとっては、どのツールを選んだいいかわからない!というのはよくあると思います。そのため、僕の独断と偏見でおすすめの無料で使えるツールを3つ紹介してみます。

1.Python

現在、データ分析ツールの代表選手といえば、Pythonと言えるでしょう。

Pythonはデータ分析やAI開発のためのライブラリ(便利なオプションのようなもの)を揃えたプログラミング言語です。プログラミング言語も、実行環境も、ライブラリも基本的に無料で利用可能です。

Macの場合は、すでにPython言語はインストールされているようです。Windowsの場合は、別途公式サイトに行ってインストールすることで使えます。

ちなみに、Pythonは、以下のようなPythonコードと言うプログラミング言語で、実施します(「#」 に続く一文はプログラミングでは「コメント」と言い、プログラミングの構文ではなく、後から見てわかるような注意書きです)

# 1から10までの数値のリストを作成

numbers = [i for i in range(1, 11)]

# 各数値を二乗した新しいリストを生成

squared_numbers = [number ** 2 for number in numbers]

print("元の数値のリスト:", numbers)

print("数値を二乗したリスト:", squared_numbers)

図:Pythonコードの例

2.R

Rはデータ分析や統計解析に特化した無料のツールです。Pythonが汎用的なプログラミング言語だったのに対して、Rはデータ分析や統計解析に特化している点が、大きな違いですね。

また、RはR言語と言うデータ分析に特化したプログラミング言語で操作するのですが、プログラミング言語を操作しなくとも、マウスで操作可能なGUIツールも揃えています(例えばRコマンダー)。

そのため、データ分析専用のツールを扱いたいが、プログラミングは苦手という人にも使いやすいツールといえます。

3.ExcelとAccess(便宜的に無料ツールとした)

ExcelとAccessはマイクロソフトの有償ソフトウェアです。そのため無料ツールとして紹介するのは矛盾があります。

ただし、企業内で使うということを前提で言えば、ほとんどの会社ですでにインストールされていると思いますので、「追加費用なしで始められる」という意味で無料ツールと言うことにさせていただきました。

もし、この記事を読んでいただいている方が、個人的に勉強でデータ分析をやってみたいとか、データサイエンティストを目指したいと言う場合には、PythonかRの2択で検討いただければと思います。

一方で、会社内の利用で、PythonやRのインストールに制約がある場合もあるかもしれません。フリーツールのインストールはNGとか、決まったツール以外の使用はNGなどですね。

このような場合は、ExcelとAccessでも十分可能です。

両者の切り分けとしては、

- Access・・・複数データの結合や1万件を超えるでデータの加工など

- Excel・・・加工が済んだデータのグラフ化、クロス集計、統計モデルの当てはめ

などになります。

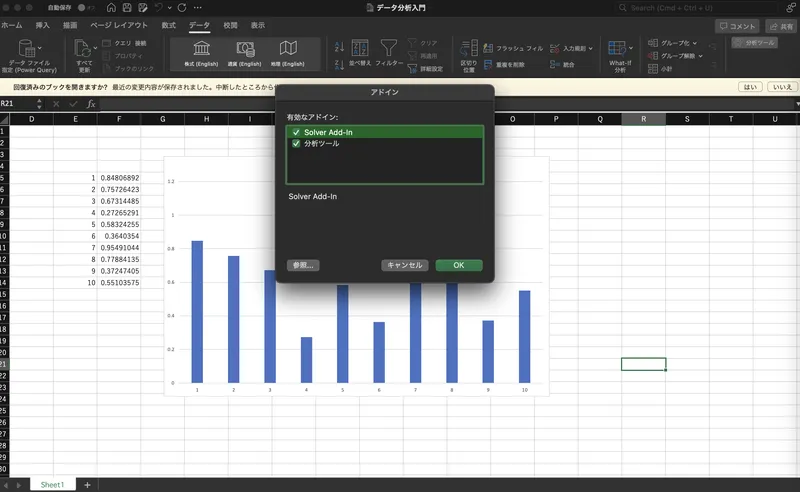

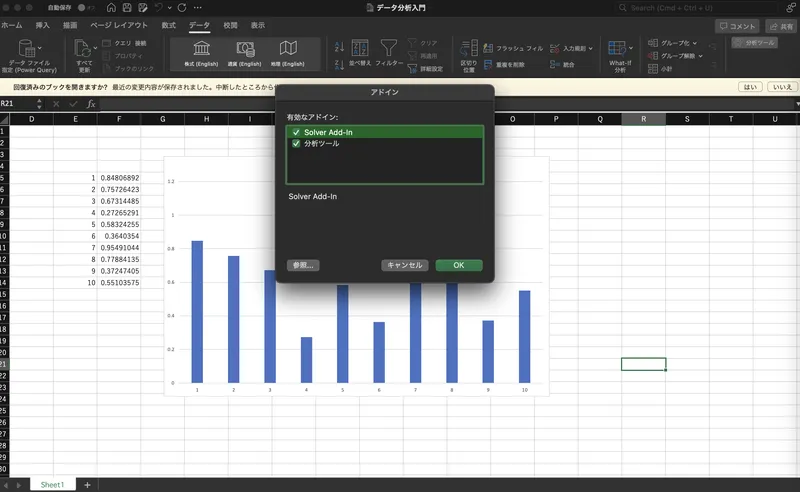

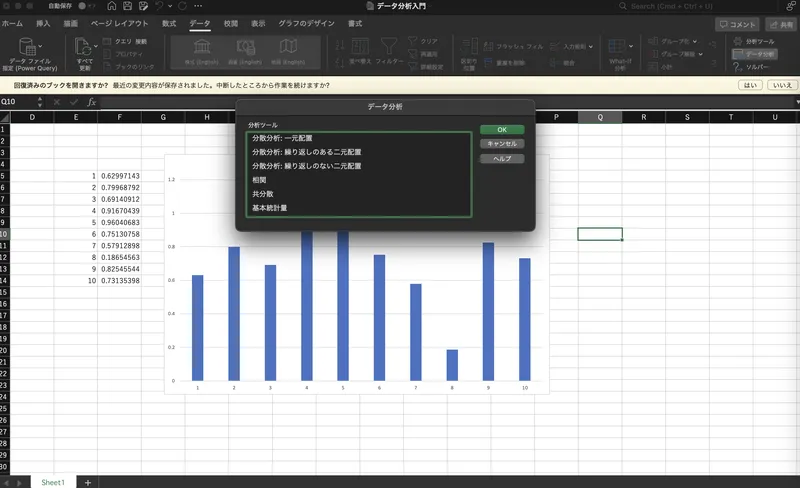

実は、Excelでも統計モデルの利用ができ、分析ツールとしてもなかなか高機能なんですね。Excelで統計解析を実施するにはまず、統計解析の機能を表示させます。操作としては、Excelでタブ「データ」を開き、右端にある「分析ツール」をクリックし、開いた画面のチェックボックス「Solber Add-In」と「分析ツール」の2つにチェックを入れます。

図:Excel、分析ツールの機能を解放!

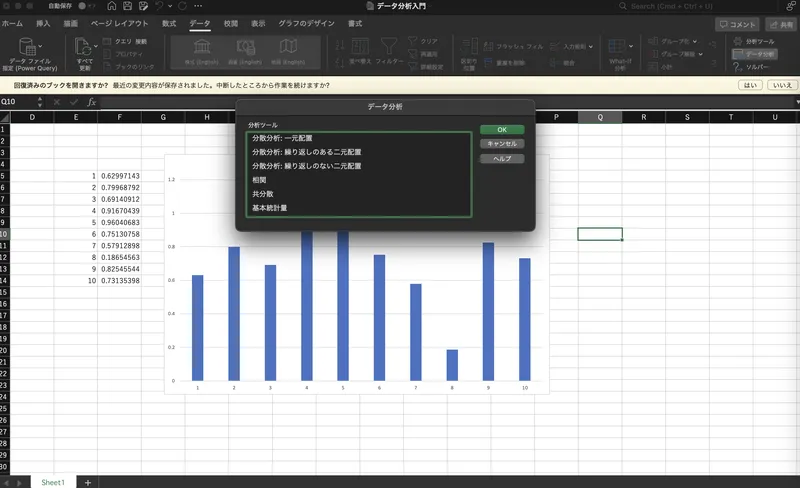

続いて、同じくタブ「データ」の右端に「データ分析」と言うボタンが新たに追加されたので、クリックすると、分析用のメニューが表示されています。

図:Excel、分析ツールのメニュー

Excelで分析したから、分析結果も大したことない、なんてことは全くあり得ません。Excelで分析する場合も、自信を持ってやってもらえるといいと思います。

分析ツールについては以下にもまとめてあるので、よかったら見てみてください!

データサイエンティストに必要なスキルとは?

僕自身、データ分析コンサルタントで、かつ、中小企業診断士として経営コンサルもやっている立場から、これまでビジネス面で見てきたデータサイエンティストには、主に、異なる2つの立場があることを感じていました。

その2つの立場は「自社データを分析するデータサイエンティスト」と「他社データ(他者データ)を分析するデータサイエンティスト」です。

自社データを分析するデータサイエンティストとは?

これは、自社内のデータサイエンスチームに所属し、自社事業のデータを分析し、自社の経営に役立てる仕事をしている方ですね。

ビジネス的には、事業会社に所属するデータサイエンティスト、などと言ったりもします。

データサイエンティストとしての特徴としては「狭く・深く」です。基本的に自社のビジネスにおけるデータの分析がメインで、利用する統計モデルや手法も限定的です。そのため、必ずしも幅広い手法に精通していなくとも良く、その分野の特定の手法に精通していれば、それで十分だったりもします。

例えば、知り合いの金融関係で利用者の与信の判定を行う分析チームの方は、与信モデルの研究をとことん突き詰めていらっしゃいます。

また、分析に使うデータについても、すでにデータ分析しやすいようにITチームが加工してくれているというように、分業作業が成立しているケースも多いですね。このようなケースではシステム的な知識がなくともデータサイエンティストとして十分に仕事に従事することが可能です。

そして、自社データ分析を進める上で、必要なデータサイエンス固有のスキルは主に次の2つとなります。

- 「データの収集と加工」のスキル

- 「データ分析」スキル

他社データ(他者データ)を分析するデータサイエンティストとは?

一方で、こちらは、主に、コンサルタントのような立場で、データ分析サービスを提供する側で仕事をしている方ですね。僕自身もデータ分析コンサルなので、こちらのデータサイエンティストと言えます。

データ分析コンサルの一番の特徴は、クライアントによって様々なデータや分析モデルを操らなければならないという点です。そのため、一つの手法を突き詰めて研究しているだけでは、仕事は務まりません。なので、「浅く・広く」が特徴ですね。

特に、お客様からデータをお預かりし分析する際、すぐにデータ分析できるような加工された綺麗なデータでいただけることは稀で、ほとんどの場合、いろんな側面からデータの加工が必要になります。

また、データのやり取りをする窓口が、実際に業務を依頼している部署(例えばマーケティング部署)ではなく、情報システム部だったりします。このような場合に、システム的な用語やり取りやデータの受け渡しができなければ、バカにされてしまうことも十分にあり得ます。

そのため、データ分析コンサルとして、一人で仕事をこなせるようになるには、データ分析以外の様々なスキルも必要になってきます。

この場合、他社データの分析をするデータサイエンティストは、必須スキルとして、さらに次のスキル必要だといえます。

他社データの分析をするデータサイエンティストにとって特に必要なデータ分析スキル

- データ分析事例の提示スキル

- データの受領・加工・集計スキル

- データ分析スキル

- 分析結果を基にしたコンサル提案スキル

ここら辺のスキルは、本を読んで理解するだけではなかなか身に付かず、日頃からデータ分析に携わらないとなかなか身に付かないでしょう。コツコツ、データとツールに触れるに限りますね!

このスキルについては以下にも解説してあるので、よかったら参考にしてください!

データサイエンスの勉強法とおすすめ書籍

僕が考える、データサイエンティストとして最低限必要なスキルは「データ分析ツールをむちゃくちゃ使いこなせること」だと考えています。もし、このスキルがあれば、会社でもビジネスでも通用できると思います。

また、最近はツールの使い方についても、インターネット上で公式マニュアルや使い方の解説コラムなどもたくさんあります。

加えて、最近ではGhatGPTがデータ分析のアシストをやってくれるので、データ分析作業もかなり簡単になってきました。とてもいい環境だと思うので、ぜひ、ChatGPTを使い倒して、ツールになれることをお勧めします!

ChatGPT時代のデータサイエンス勉強法:

- データ分析入門者は、自分が使うデータ分析ツールを早い段階で決めてしまう!!

- 書籍は、全体像をざっと、わかりやすく勉強したい場合など、最小限に抑える!!

- 入門書を勉強した後は、実データとツールを使って、どんどん分析しながら勉強すること!!

- 分析については、わからない点は積極的にChatGPTを使い、効率化を目指す!!

- 体系的に理解したい場合は、インターネット上のマニュアルなどの公式情報に普段からあたるようにする

このように考えると、これまではデータサイエンスを勉強するには本をたくさん用意しなくてはいけませんでしたが、最近では、ほとんど本は不要です。そのため、データサイエンスを勉強する場合、購入する書籍は最小限に抑え、ネットの情報を効率よく使うことが、実は、データ分析上達のカギだと思います。

また、データ分析を行う上で、超おすすめの基本書をご紹介します。

データ分析の基礎については、多くの名著がありますが、その中でも一つだけおすすめしたいと思います。今まで、算数や数学に遠のいていた方にとっては、以下の本については、入門書といっても正直、非常に難解だと感じると思います。しかし、何度も何度も熟読することで、理解できる内容だと思います。そのため、次の本については、一回読んだだけで、理解するものだとは、絶対に思わずに、長年、何度も熟読するつもりで、挑んでみてください!

タイトル:「心理統計学の基礎」

おすすめ度:★★★★★

この本は僕がデータ分析の入門者だった頃に勉強した本で、今から20年以上も前の2002年初版の本です。ちなみに、この記事を書くにあたって、評判の良いデータ分析の入門書を実際に、かなりの冊数を購入し、読んでみました。しかし、残念ながら、僕が調べた限り、本書を超える入門書は見当たりませんでした。

その他、お勧めの勉強法や書籍については以下も解説してあるので、よかったら見てみてください!

まとめ

以上、僕の経験から、データ分析初心者に向けたデータ分析の解説でした。データサイエンスの基本のキの内容ですが、皆さんのお役に立てれば幸いです!